导读

这是一篇非常特别的文章,其中一个审稿人评价这篇文章是标签平滑和知识蒸馏领域有突破性的一篇文章,并给出了 8 分的高分。为什么说它特殊呢,因为论文的核心并不是常见的刷点打榜的工作,而是在澄清和纠正过去一篇比较有名的文章中提出的一个重要发现,基于这个发现衍生出来的观点和在这个问题上的认知,进而让人们更好的理解标签平滑和知识蒸馏的工作原理,那篇被纠正的文章发表于 NeurIPS 2019[1],作者之一是我们大家都非常熟悉的深度学习先驱之一的 GeoffreyHinton。

大家应该很好奇,大佬的文章也会有不完善的观点吗?答案是肯定的。人们对于某些问题的认知本来就是在曲折中不断前进的。我们首先来介绍一下 Hinton 那篇文章在讲一个什么事情。Hinton 这篇文章主要是在探究和解释标签平滑的机制和工作原理,下面这张图很好解释了这种机制:

这篇文章里第一个有意思的发现是:Label smoothing encourages the activations of the penultimate layer to be close to the template of the correct class and equally distant to the templates of the incorrect classes.这是一个非常重要的发现,它的大意是在说标签平滑可以消除类内样本之间的差异,让学到的同一类别的特征表达更加紧凑。

更具体来说,比如狗这个类别的图片通常会包含不同的姿态,拍照角度,曝光程度,不同背景等等,标签平滑可以很好的消除不同样本特征中这些差异的或者称为 noisy 的信息,而更多地保留它的高层语义信息,即狗这个类别信息。

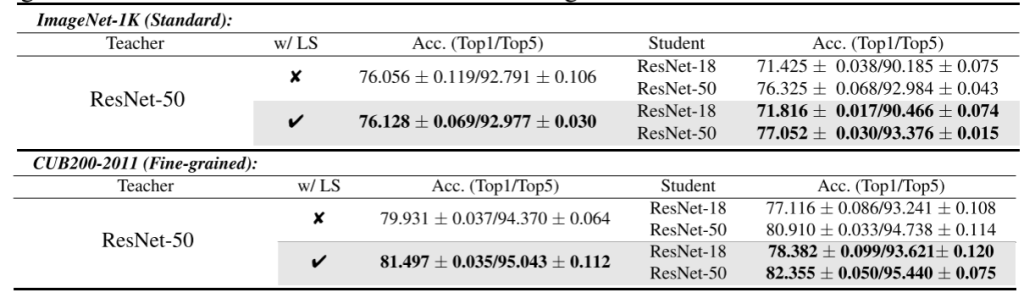

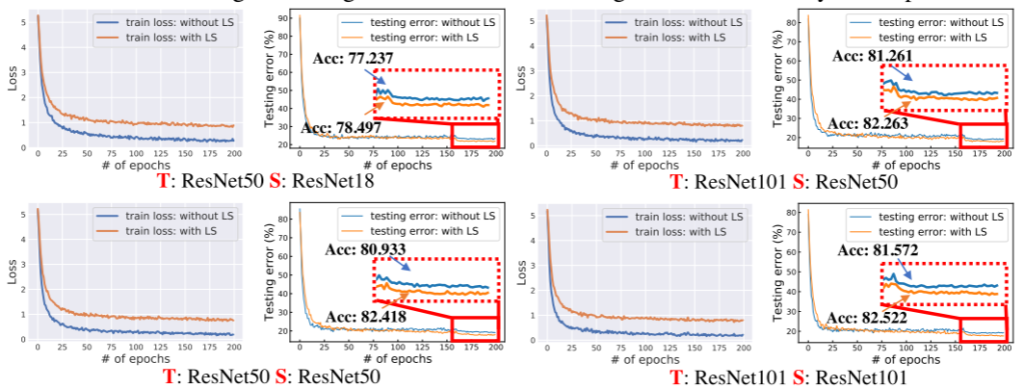

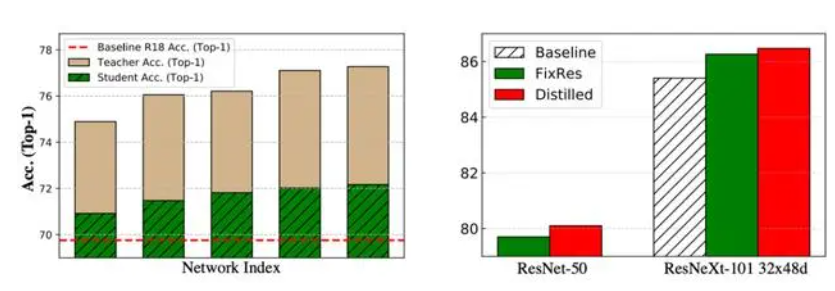

基于标签平滑这个特点,作者进一步提出了一个观点,即:If a teacher network is trained with label smoothing, knowledge distillation into a student network is much less effective. 怎么解释这个结论呢?如上图最后一行所示,右侧某类样本在使用标签平滑之后会聚集在类中心点,因此不同样本到其他两种样本的距离信息会趋向于相同,即标签平滑抹去了同一类别不同样本到其他类别的距离的细微差别,作者认为这种现象对于知识蒸馏来说是有害的,因为蒸馏正是需要 teacher 能拥有这种捕捉同一类别不同样本之间细微差别的能力才会有效的,因此他们还认为: a teacher with better accuracy is not necessarily the one that distills better. 大概意思就是 teacher 性能好对于知识蒸馏来说并不重要。

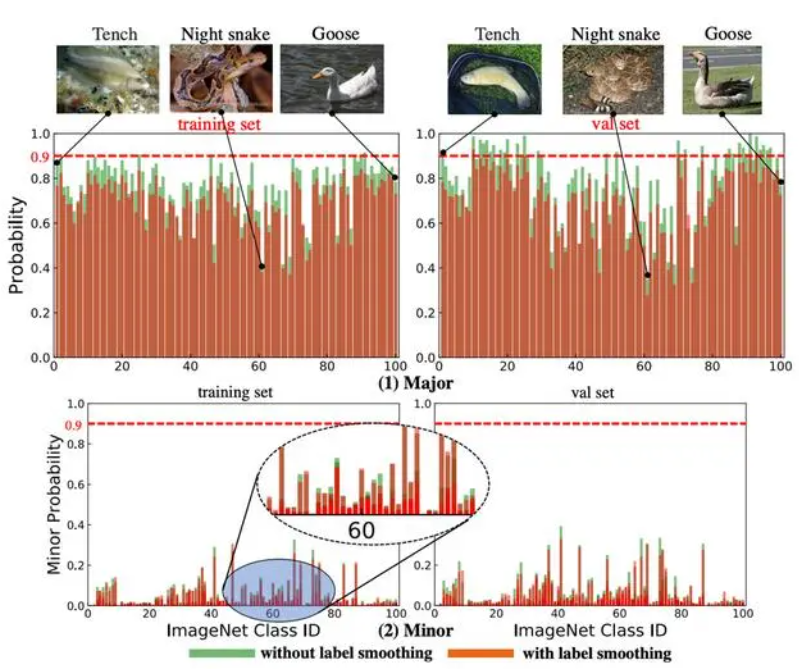

本文作者首先重现了NeurIPS 2019那篇文章中的可视化过程,并证明了上述论文中提到的现象是真实存在并可重现的,但是他们还有了一个新的惊人的发现:

如果我们重新来审视上图中两个语义相似的类别(每个子图左侧的两个靠近的类别),当使用标签平滑训练的teacher时,同一类别样本聚集会更加紧密,因为标签平滑会促使每个样本与该类中其他样本的类中心等距,而紧密的聚类会显著促使语义相似但不同类别的样本的表达变得更加可分离,即两个类中心距离 Dc 增大了,这进一步体现为语义相近但是不同类别的样本获得更可区分的特征。

这个现象非常重要,因为这些相似类别(分辨困难的类别)是提高分类模型性能的关键。一般来说,我们没有必要去衡量"狗和鱼有多像或者有多不像",因为我们有足够的线索和特征来区分它们(即右侧类样本到左侧类别的距离不重要),但对于细粒度的类别之间比如不同种类的狗的信息对于区分它们是非常关键的。

上述分析作者从原理上解释了为什么标签平滑和知识蒸馏并不冲突,为了更好地阐述两者关系,作者提出了一个能定量地衡量被抹去信息大小的指标,称之为stability metric,它的数学表达如下:

Comments | NOTHING